Während die mechanische Konstruktion einer Inspektionsanlage bereits im Rechner erfolgt, werden keinerlei physikalische Eigenschaften von Optik und Beleuchtung simuliert. Dabei haben die Konzeption der Beleuchtung und der Kameraaufbau den stärksten Einfluss auf die Qualität eines Inspektionssystems. Durch die Variation des Aufnahmewinkels zwischen Kamera und Beleuchtung können bestimmte Arten von Defekten auf einer Oberfläche stärker sichtbar und somit detektierbar gemacht werden. Hinzu kommen die optischen Eigenschaften des Materials, das geprüft werden soll.

So hat zum Beispiel Kunststoff ein ganz anderes optisches Verhalten als Metall. Sind die zu prüfenden Produkte geometrisch relativ einfach aufgebaut, kann der Ingenieur im Labor empirisch feststellen, wie ein optimales Beleuchtungs- und Kamerasetup auszusehen hat und dementsprechend das Inspektionssystem konzipieren.

Werden die Produkte jedoch in Geometrie und Materialzusammensetzung komplexer, ist es nicht mehr möglich, ein passendes Inspektionssystem durch Try-and-Error-Verfahren zu designen. Nimmt man beispielsweise eine Thermoskanne aus Aluminium mit einem Handgriff aus Kunststoff, so ist es fast unmöglich, eine Maschine zur vollautomatischen Inspektion zu entwickeln. Verwendet man einen Roboter, um den Winkel zwischen Oberfläche und Beleuchtung präzise einzuhalten, scheitert dies spätestens am Handgriff. Hinzu kommt, dass das Reflexionsverhalten des Aluminiums anders ist als das des Kunststoffs. Für den Entwickler bedeutet dies, dass er abhängig vom Material den Winkel von Beleuchtung und Kamera ändern muss. Sonst könnte es passieren, dass das System zum Beispiel Kratzer auf der Aluminiumoberfläche sicher erkennt, sie aber auf der Kunststoffoberfläche nicht findet.

Aber was kann man tun, wenn die Bauteile komplizierter werden? Wie lässt sich trotz zunehmender Individualisierung von industriell hergestellten Produkten ihre Prüfung automatisieren? Eine Lösung wäre, die gesamte Inspektion im Rechner zu konstruieren und physikalisch zu simulieren – also eine virtuelle Bildverarbeitung. Diese Idee entstand während der Zusammenarbeit der AG „Computergrafik“ der TU Kaiserslautern und der Abteilung „Bildverarbeitung“ des Fraunhofer ITWM (Fraunhofer-Gesellschaft auf der Vision: Halle 1, Stand G42) in den vergangenen beiden Jahren im Leistungszentrum „Simulations- und Software-basierte Innovation“.

Zu Beginn waren die beteiligten Ingenieure und Wissenschaftler noch der Meinung, dass es die notwendigen mathematischen Werkzeuge bereits gibt und nur kombiniert werden müssen. Ziel war es, mittels vorhandener Computergrafik-Methoden (Raytracing), Materialmodellen und Kameramodellen synthetische Bilder zu erzeugen und auf diesen Bildverarbeitungsalgorithmen zu testen. Weiterhin suchte das Team nach Verfahren zur Bestimmung der optimalen Positionen von Kamera und Beleuchtung. Sehr schnell stellte sich heraus, dass es zwar vereinzelt Teillösungen gab, aber letztlich waren alle vorhandenen Methoden entweder ungenügend oder nicht sinnvoll kombinierbar. Das Team nahm dies zum Anlass, eine interdisziplinäre Forschungsgruppe zu etablieren, deren langfristiges Ziel die Implementierung einer industrietauglichen Simulation ist. Neben diesem langfristigen Ziel sollen aber in kurzer Zeit verschiedene Teilziele erreicht werden, die dann direkt in Industrieprojekten der Fraunhofer-Abteilung eingesetzt werden können.

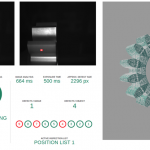

Eines der ersten Forschungsergebnisse war ein Algorithmus, der bei gegebenem 3D-Modell des Prüflings sowie den Kamerapositionen und Beleuchtungswinkeln berechnet, welche Oberflächenbereiche überhaupt sicher geprüft werden können. Der Nutzer kann weiterhin bestimmte Oberflächenareale von der Prüfung ausschließen, wenn dort keine Inspektion nötig ist. Das Verfahren berücksichtigt dabei nicht nur die Bereiche, die von der Kamera „gesehen“ werden, sondern berechnet auch weitere Parameter wie zum Beispiel die Bildqualität. Im Rahmen dieser Entwicklung entstand ein Demonstrator, bestehend aus einem Roboter mit Kamera und Beleuchtung.

Ein ganzes Inspektionssystem zu simulieren und anschließend seine Effektivität zu modellieren, ist eine wesentlich komplexere Aufgabe. Wie bereits erwähnt, würde dies auch die Berücksichtigung oder Modellierung aller anderen Komponenten des Systems erfordern, die zur Inspektion eines Produkts verwendet werden, wie beispielsweise die technisch möglichen Bewegungsabläufe der Roboteraktorik mit den montierten Kameras und Beleuchtungen. Dies führt zu einer weiteren Frage: Wie berechnet man optimale Kamera- beziehungsweise Beleuchtungspositionen im Bezug zu einem Prüfling?

Neuer Algorithmus sucht die

optimale Beleuchtungssituation

Zumindest teilweise kann diese Frage mittels eines neuen Algorithmus der Arbeitsgruppe beantwortet werden. Dieses Verfahren tastet anhand des 3D-Modells des zu prüfenden Produkts seine gesamte Oberfläche ab und berechnet anhand der lokalen Krümmung, welche Oberflächenpunkte potenziell wichtig sind und somit im Blickfeld der Kamera sein müssen. So zeigt sich, dass Bereiche mit starker Krümmung mehr Positionen erhalten als flache Bereiche. Das Ergebnis des Algorithmus ist eine Menge von Positionen, die dann für die Bahnplanung des Roboters verwendet werden können. Dazu arbeitet die Arbeitsgruppe mit anderen Forschungsgruppen aus dem Bereich Robotik zusammen.

Aktuell ist die am Fraunhofer ITWM entwickelte Revolving/Evolving Product Inspection (EPI) ein Schritt auf dem Weg zur virtuellen Inspektion. Bei der umlaufenden Inspektion werden nicht nur die Rahmenbedingungen wie Bauteilgeometrie und Oberflächenbeschaffenheit möglichst exakt berücksichtigt, sondern das System hat auch gelernt, wo mögliche Problemstellen bei der Analyse liegen können.

„Gefüttert“ wird es zunächst mit den CAD-Daten eines Werkstücks. Das heißt, das Inspektionssystem weiß, wie ein Gutteil aussehen soll. Die Software ist so konzipiert, dass sie anhand des spezifischen Produkts individuelle Scanpfade für die auf einen Drehteller platzierten Objekte berechnet.

Die Forscher aus der AG Computergrafik an der TU Kaiserslautern wiederum beschäftigen sich mit den Methoden des Physically Based Modelling sowie Visualisierungstechniken. Dies ermöglicht Modellbildungen basierend auf physikalischen Prinzipien der Optik. Dazu sind bereits mehrere Promotionen angelaufen, weitere Themen werden in den nächsten Monaten ausgeschrieben. Eine immer noch offene Frage ist, wie man stochastisches Materialmodell umsetzt. Materialmodelle beschreiben, wie ein bestimmtes Material Licht reflektiert, abhängig von Bestrahlungswinkel und Wellenlänge, ein typisches Modell ist zum Beispiel die bidirektionale Reflektanzverteilungsfunktion (BRDF ).

Aus verschiedensten Gründen ist die BRDF unzureichend für eine physikalische Simulation, vor allem, wenn bestimmte Eigenschaften von Materialien eine gewisse Wahrscheinlichkeit haben, aber nicht unbedingt immer auftreten (deshalb der Begriff stochastische Materialmodelle). Dieser Effekt tritt in der Praxis sehr häufig auf, ein Beispiel sind geschliffene oder polierte Gussteile. Je nach Beleuchtungswinkel kann es passieren, dass extreme Reflexionen entstehen und das Bild der Kamera dann in bestimmten Regionen übersteuert ist.

Diese Reflexionen entstehen durch minimale Abweichung in der Bearbeitung, also etwa beim Schleifen. Das heißt, zwei eigentlich baugleiche Werkstücke haben diese Reflexionen an jeweils anderer Stelle oder gar nicht. Es gibt also eine bestimmte Wahrscheinlichkeit, dass dieser Effekt auftritt und dies muss in die Modellierung des Materials eingehen. Sonst kann es passieren, dass die Kamera zwar eine geometrisch optimale Position zur Werkstückoberfläche hat, aber das Bild zum Teil übersteuert ist und somit an dieser Stelle nicht sicher geprüft werden kann.

Alles dies sind kleine Schritte auf dem Weg zur vollständigen, physikalisch korrekten Simulation von Inspektionssystemen. Ziel ist eine Software-Infrastruktur, welche die komplette Inspektionsumgebung simuliert. Dazu gehören neben den Eigenschaften des Prüfstücks auch die Eigenschaften aller Handwarekomponenten (Beleuchtung, Kamera, Optik etc.). Die Architektur der Software soll dabei so gestaltet werden, dass kommerzielle Anbieter von Sensoren oder Beleuchtungen ihre produktspezifischen Eigenschaften wie beispielsweise Kameraparameter einpflegen können, ohne sensibles Know-how preisgeben zu müssen. Das System wird also herstellerunabhängig sein. ■

Mehr zum Thema Messe Vision