In der industriellen Inspektion war die Bildverarbeitung schon immer die Kerndisziplin. Vor der Deep-Learning-Ära analysierten Bildverarbeitungsingenieure oft nur wenige Beispielbilder und entwickelten daraus aufwendige mathematische Modelle, die die sichtbaren, relevanten geometrischen oder statistischen Strukturen so gut wie möglich beschreiben. Sobald neue Erkenntnisse vorhanden waren, musste dieser zeit- und kostenintensive Entwicklungsprozess wiederholt werden.

Moderne Lösungsansätze mit Convolutional Neural Networks (CNN) versprechen diesen Prozess wesentlich einfacher und vor allem kostengünstiger zu gestalten, da alle relevanten Informationen automatisch aus den Trainingsdaten extrahiert werden. Sobald neue oder erweiterte Trainingsdaten verfügbar sind, kann das CNN-Trainingsverfahren problemlos wiederholt werden, und die einzig dafür notwendige Ressource ist ausreichende Rechenleistung.

Da beim Einsatz von Deep Learning alle Informationen aus den Trainingsdaten abgeleitet werden, ergeben sich jedoch auch Fallstricke. So werden zum Beispiel alle in den Trainingsdaten nicht abgedeckten charakteristischen Erscheinungsvarianten vom CNN wahrscheinlich nicht richtig interpretiert. Es ist daher erfolgskritisch, dass die Trainingsdaten für neuronale Netze alle unterschiedlichen Erscheinungsformen repräsentativ abdecken.

Zwar sind CNNs in der Lage, die präsentierten Trainingsdaten in gewissem Maße zu verallgemeinern, doch könnte diese Verallgemeinerung speziell für Klassen mit geringem Datenvolumen zu einem Overfitting führen und so die Erkennungsleistung gefährden. Auch können vollständig fehlende Objektklassen üblicherweise nicht korrekt verarbeitet werden. Nur in speziellen Konfigurationen oder unter Zuhilfenahme spezieller Maßnahmen erkennen CNNs tatsächlich Neues (Anomalien).

Die akademische Gemeinschaft hat mehrere umfassende Datensätze zusammengestellt, auf deren Grundlage die Potenziale neuer Deep-Learning-Algorithmen untersucht werden. Für industrielle Anwendungen jedoch sind große Datenbanken – beispielsweise Bilder von Produktionsfehlern – oft nicht verfügbar.

Unzureichende und unausgewogene Datensätze enthalten immer einen Bias, der dazu führt, dass CNNs jene Aspekte einer Aufgabe, die von Trainingsdaten abgedeckt wurden, verallgemeinern, jedoch für Aspekte, die nicht abgedeckt wurden, blind erscheinen. Aufgrund der Komplexität großer Datenmengen sollte die Gefahr der Datenverzerrung stets beachtet werden. Zur Vermeidung von Verzerrungen sollten Trainingsdaten sorgfältig ausgewählt und erweitert werden und bei jeder Erweiterung das CNN neu trainiert werden.

Künstliche Daten sollen die Lösung bringen

Während neuronale Netze für das Training umfangreiche Datensätze benötigen, ist jedoch für reale Aufgabenstellungen Datenmangel ein bekanntes Problem. Generative Adversarial Networks (GAN) sind eine neue, 2014 veröffentlichte Methode auf Basis von CNNs, geeignet zur Erzeugung künstlicher Daten. Dabei werden zwei CNNs, ein Counterfeiter-Netzwerk und ein Discriminator-Netzwerk darauf trainiert, gegeneinander zu arbeiten.

Das Counterfeiter-Netzwerk hat die Aufgabe, die verfügbaren realen Trainingsdaten plausibel nachzuahmen und einige neue Strukturen bereitzustellen. Das Discriminator-Netzwerk ist darauf trainiert, aufzudecken, ob Bilder künstlich erzeugt worden sind oder nicht.

Während der Diskriminator die Aufdeckung von Fälschungen verbessert, optimiert der Generator die Erzeugung plausibler Bilder – so lange bis der Diskriminator zwischen den gefälschten Bildern und den realen Bildern nicht mehr unterscheiden kann.

Die Entdeckung von GANs weckte die Hoffnung, dass damit auch geringe Mengen von Trainingsdaten einfach mit ausreichenden Variationen ergänzt werden könnten, um so den Mangel an realen Daten auszugleichen. Tatsächlich können für einige Anwendungsfelder – wie zum Beispiel Unterhaltungs- oder Modeanwendungen – bemerkenswerte Ergebnisse erzielt werden, wenn künstlich generierte nicht von echten Bildern unterscheidbar sind. Selbst Menschen können den Unterschied nicht erkennen.

Tatsächlich kann ein GAN keine wesentlich neuen künstlichen Daten ohne einen Hinweis auf reale Daten erzeugen. Für die industrielle Inspektion, bei der es auf Präzision und Zuverlässigkeit ankommt, sollten die künstlich erzeugten Daten mit den realen Bildern übereinstimmen – nicht nur jene, die plausibel erscheinen. Dennoch können selbst das Messen und Prüfen der generierten Daten mit realen Daten nicht zuverlässig durchgeführt werden.

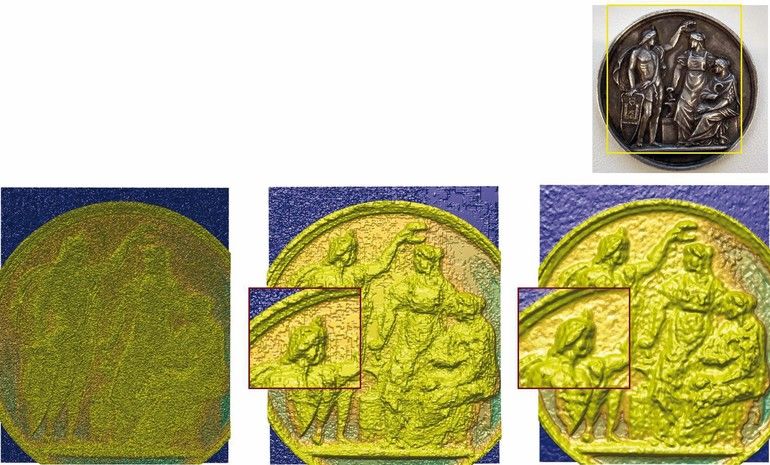

Für einige Anwendungen besteht die Möglichkeit das GAN mit einer herkömmlichen Methode zur Erzeugung künstlicher Daten wie dem Rendern zu kombinieren. Das Rendern erzeugt eine große Menge an geometrischen Variationen, ahmt jedoch normalerweise die Eigenschaften der realen Bilderfassungssysteme nicht korrekt nach. GANs können verwendet werden, um den sogenannten Style-Transfer durchzuführen, die statistischen Kameraeigenschaften zu erlernen und auf die gerenderten Bilder anzuwenden ohne deren geometrischen Inhalt zu beeinträchtigen.

Deep Learning ist eine ausschließlich datengetriebene Methode deren Ergebnis abhängig ist von der Datenqualität. In einem industriellen Umfeld ist es eventuell nicht möglich, sich vollständig auf die Qualität eines Trainingsdatensatzes zu verlassen. Für diesen Fall empfehlen wir, Deep Learning in sorgfältig ausgewählte Datenerfassungs- und Bildverarbeitungs-Pipelines zu integrieren und neuronale Netze lediglich für ausgewählte Teilbereichen der Auswertungspipeline anzuwenden.

Dabei sollten herkömmliche Bildverarbeitungsmethoden beibehalten werden, solange diese zufriedenstellend funktionieren. Beispielsweise könnten moderne photometrische und Multi-View Akquisitionen zusammen mit Computational Imaging einen wertvollen Input für ein CNN darstellen.

Auf diese Weise kann man die Steuerbarkeit von Datenqualität und Informationsgehalt durch Bildverarbeitung nutzen und komplexe, hochdimensionale Zusammenhänge aufdecken, die kein anderes Verfahren so gut erfassen kann wie Deep Learning. ■

Die Autoren

Petra Thanner

Senior Research Engineer

High-Performance Image Processing

AIT Austrian Institute of Technology

Daniel Soukup

Scientist

High-Performance Image Processing

AIT Austrian Institute of Technology

Hier finden Sie mehr über: